ANALYS Utvecklingen av militär AI och autonoma vapensystem går fort. Vilka utmaningar innebär den? Vad krävs i form av reglering och räcker dagens juridiska system till? Vintern 2023 röstades den första FN resolutionen igenom om autonoma vapensystem. Resolutionen ger FN:s generalsekreterare i uppdrag att samla in synpunkter om autonoma vapensystem och lämna in en rapport till generalförsamlingen.

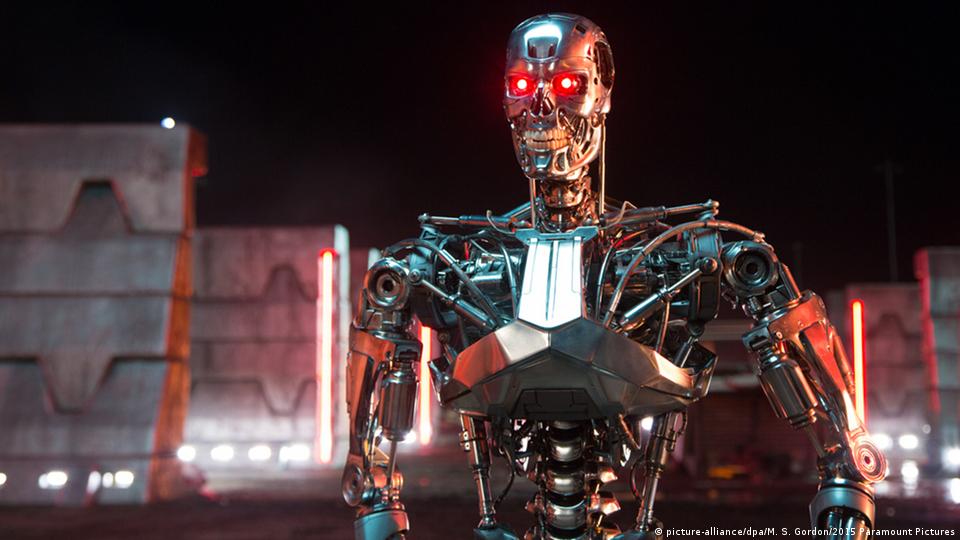

FOTO: picture-alliance/dpa/M. S. Gordon/2015 Paramount Pictures

När de flesta människor hör ordet “mördarrobot” går tankarna antagligen till Arnold Schwarzenegger klädd i en skinnjacka och solglasögon. I filmen Terminator fick människoliknande robotar människolika medvetanden, blev onda och började döda sina skapare och så småningom hela världen. Lyckligtvis är den typen av artificiell intelligens (AI) som kan leda till en blivande terminator, fortfarande bara en idé.

Men frågan ligger nu på bordet för FN:s medlemsstater och Generalsekreteraren har uppmanat medlemsstaterna att komma fram till ett förbud mot autonoma vapensystem senast 2026.

Frågan om autonoma vapensystem har aktualiserats av pågående väpnade konflikter. Det ryska fullskaliga anfallskriget mot Ukraina där båda parter använt drönare med ökande autonomitet som en viktig del av krigföringen och i kriget mot Gaza där Israel använder AI-system för att identifiera måltavla.

Generell och snäv AI

Vi är åratal, om inte decennier eller sekler, bort från att nå generell artificiell intelligens – alltså människolik artificiell intelligens – som kan utföra en rad olika uppgifter inom ett brett spektrum. Den artificiella intelligens vi har idag är så kallad snäv AI där maskiner kan programmeras för att utföra specifika uppgifter på ett begränsat område. Den teknologiska utvecklingen har betytt stora framgångar inom exempelvis medicin, jordbruk och astronomi men det har också medfört stora risker.

Ett av de farligaste användningsområdena för snäv AI är autonoma vapensystem, även kallade mördarrobotar. Vapensystem som självständigt kan söka, identifiera och förstöra mål. Till skillnad från generell AI är mördarrobotar bara år, om inte månader bort. Mördarrobotar har inget medvetande, de är programmerade med algoritmer utformade för att hjälpa dem sortera människor i olika kategorier; baserat på exempelvis längd, vikt, kroppstemperatur och hårfärg. Efter de har programmerats kan de dock, och det är själva meningen, utforska fritt och attackera mål som anses uppfylla de förprogrammerade kraven.

Att reglera eller inte reglera

Det finns tydliga regler och lagar som bestämmer vad som är tillåtet i krig och som ska skydda både soldater och civila. Vapen som dödar urskillningslöst eller orsakar oproportionerlig skada har förbjudits i en ständigt utvecklande ram av internationell humanitär rätt, alltså krigets lagar. Det finns principer i den internationella humanitära rätten som mördarrobotar inte skulle kunna följa. En process pågår därför för att kunna reglera dessa vapen. De nuvarande reglerna skrevs inte med AI och maskininlärning i åtanke. Därför måste den internationella rätten expanderas för att ta hänsyn till AI-system.

En hörnsten i alla lagar, vare sig internationella eller nationella, är ansvarsutkrävning. För alla steg som tas måste man kunna peka på ansvarig aktör som tar på sig ansvar om något går fel. Vilken aktör har ansvar enligt internationell rätt i de fall en mördarrobot gör något fel? Maskiner har inga rättigheter eller skyldigheter enligt lagen och kan därför inte heller hållas ansvariga inför den.

En viktig princip i internationell humanitär rätt är också principen om distinktion. Principen säger att varje aktör i en väpnad konflikt måste skilja på civila och stridande. I mer traditionell krigföring kan dessa särskiljas genom kamouflageuniformer, lappar, flaggor och andra markörer. I inbördes konflikter och asymmetriska väpnade konflikter är det mindre tydlig skillnad mellan kombattanter och civila. För att kunna följa distinktionsprincipen krävs det därför mer än bara enkel kategorisering av uniformerade kontra civilklädda personer. Det krävs komplexa bedömningar som är svåra att förutse och planera för. Existerande AI-system, både de som används civilt och i militära situationer, testas i labb- situationer där alla variabler kan kontrolleras. Ju mer komplexitet som introduceras till systemet, desto svårare blir det att förutsäga hur ett system kommer att agera.

Proportionalitet

En annan princip i internationell humanitär rätt är proportionalitet. Proportionalitetsprincipen säger att den som använder våld alltid ska göra en bedömning av om de civila föremål eller personer som skadas står i proportion till de militära mål som man förväntar sig att uppnå. Denna princip förstärks ytterligare av regler som kräver försiktighet vid attack och en förmåga att stoppa eller pausa en attack om den skulle kunna orsaka alltför stor civil skada. Precis som distinktionsprincipen är det svårt att kunna förutse och planera för situationer och se till att attacker är proportionerliga. Det handlar inte om enkel input och output och lätta uträkningar utan kräver att man fattar svåra beslut och att man kan motivera dem. Detta skulle vara svårt, om inte helt omöjligt, att tillförlitligt och exakt programmera en sådan bedömningsförmåga in i en maskin.

Det objektiva vapnet?

Men, är det bara dåligt att krig blir mindre mänskligt? Kan det inte finnas fördelar med en mer “objektiv” krigföring, kanske vissa frågar sig. Om krigföringen förs av maskiner kanske vi slipper baksidorna med mänskliga fördomar och bedömningar, som rasistiska och sexistiska strukturer?

Vi kan felaktigt tro att alla beslut som tas av en dator är bättre, de blir inte arga, hungriga eller hämndlystna. Därför är deras beslut mer objektiva. Även om vi rationellt sett vet att generell artificiell intelligens inte existerar och därför fattar algoritmerna bara beslut baserat på de datamängder de får från oss. Det handlar om en grundläggande misstro mot mänskligheten och en övertro på teknik.

Rasism är en aspekt som diskuteras i förhållande till autonoma vapen. AI i sig är inte rasistiskt, det kan det inte vara, den har inga känslor. Det betyder dock inte att den är objektiv. Vad algoritmer gör är att de lär sig av befintliga datamängder och extrapolerar. Därför reflekterar de samhället där de är programmerade. Algoritmer som kategoriserar människor kommer därför att återskapa fördomar och stereotyper som finns inom de kulturer där de skapas och från vilka de kommer att få information för att extrapolera och leverera resultat. Det är därför vi ser att mjukvara för ansiktsigenkänning förväxlar rasifierade personer för varandra, igen (https://innocenceproject.org/artificial-intelligence-is-putting-innocent-people-at-risk-of-being-incarcerated/ ) och igen (https://www.washingtonpost.com/technology/2019/12/19/federal-study-confirms-racial-bias-many-facial-recognition-systems-casts-doubt-their-expanding-use/)

Det är också en del av en större trend som har gått mot att artificiellt försköna krig. Krig kan inte göras humant, krig är i sig inhumant, våldsamt och fult. Men det kan säljas som humant genom att skapa ett avstånd mellan förövare och offer. Mellan de vars hem blir slagfält och de vars regeringar skickar ut mördarrobotar. Genom att använda mördarrobotar kan man sälja en idé att krig blir mer humant, det kan förvisso bli det för de soldater som slipper skickas in till krig. För de som utsätts för dessa vapen blir det tyvärr motsatsen.

Säkerhetsrisker

Mördarrobotar kommer inte bara med juridiska och etiska utmaningar, de utgör också en säkerhetsrisk. Ett grundläggande hinder för att starta krig är att det innebär en investering av resurser, både finansiella och mänskliga. Att starta eller föra ett krig kräver att den politiska ledningen motiverar att soldater skickas ut för att skadas eller dödas och med det beslutet kommer också risken för kritik när skadade och döda återvänder. Det sätter press på politiska ledare att inte starta krig lättvindigt eftersom det kan betyda bakslag i opinionen. Utan detta hinder sänks tröskeln för att starta ett krig. Stater som har mördarrobotar kan helt enkelt skicka ut några maskiner för att göra det smutsiga arbetet utan att behöva oroa sig för politiska kostnader.

En annan säkerhetsrisk är också det faktum att användningen av autonoma vapen kan leda till en konfliktupptrappning som skulle undvikas om mer komplexa situationsanalyser genomfördes. Om en person konstaterar att en militär aktion kommer att orsaka för stor skada eller oavsiktliga och oproportionerliga skador på civila personer eller föremål, kan den personen välja att dra sig tillbaka och tänka om. När det gäller mördarrobotar finns det ingen garanti att maskinen pålitligt kan göra den helhetsbedömning som krävs för att stoppa ett händelseförlopp den har startat.

Scenarierna ovan förutsätter dessutom både att maskinerna fungerar som de ska och en nivå av cybersäkerhet som för närvarande inte kan garanteras. Frågan om cybersäkerhet har varit en aktuell fråga som oroar många aktörer, vilket har lett till en ökning av institutioner och forskningsfonder ämnade till att stärka vår cybersäkerhet. Samtidigt har vi också sett många fall av sårbarheter i cybersäkerhet som kan och har utnyttjats. Berättelser om livsmedelsbutiker (https://www.svt.se/nyheter/inrikes/it-attacken-mot-coop-detta-har-hant) , banker (https://www.svt.se/nyheter/inrikes/swedbank-utsatt-for-cyberattack) och oljebolag (https://www.tn.se/article/13678/hackerattack-mot-europeiska-oljehamnar/) som utsätts för olika attacker och krav på ransomware har passerat nyhetsflöden på sistone.

Effekterna av dessa attacker visar hur sårbart samhället är för attacker. De visar också hur långtgående och förödande det skulle vara om mördarrobotar saboterades, hackades och togs över av fiendestater och icke-statliga aktörer. Det har inte funnits tillräckligt med bevis som visar att dessa risker har tagits i beaktande på allvar när man analyserar effekterna av mördarrobotar på den nationella säkerheten.

Ett problem som står i centrum för mördarrobotar, bortom frågorna om lag och säkerhetspolitik, hur viktiga dessa än må vara, är den centrala idén att vi kommer att överföra beslutet om mänskligt liv och död till en maskin. Alla dessa aspekter är varför FN generalsekreteraren, Internationella Röda korskommittén och fler än 100 länder kallar för nya internationella lagar som förbjuder och reglerar mördarrobotar. Det borde den svenska regeringen också driva.

Deborah Biniam Solomon, kampanjledare på Svenska Freds- och Skiljedomsföreningen & sakkunnig inom mördarrobotar.

Redaktör: Gerd Johnsson-Latham

Vill du skriva en text där du kommenterar, diskuterar eller kritiserar detta inlägg? Kontakta redaktionen på red.manskligsakerhet@gmail.com.

Ge ett frivilligt bidrag till vår redaktion och stötta fler nytänkande perspektiv på säkerhetsfrågor! Swish: 123 383 91 31, Banköverföring: SEB 5215 – 1116611

Lämna ett svar